Text: Thomas Brandstetter

Erschüttert blickt US-Präsident Richard Nixon in die Kamera. Er muss der Nation eine niederschmetternde Nachricht verkünden: »Das Schicksal hat bestimmt, dass die Männer, die sich zum Mond aufgemacht haben, um ihn in Frieden zu erkunden, auf dem Mond bleiben werden, um in Frieden zu ruhen.«

Apollo 11 ist gescheitert, Neil Armstrong und Buzz Aldrin sind dem Tod geweiht. »Jeder Mensch, der in den kommenden Nächten zum Mond aufschaut, wird wissen, dass es eine Ecke einer anderen Welt gibt, die für immer der Menschheit gehört.«

Muss die Geschichte umgeschrieben werden? War der größte Triumph der Menschheit in Wahrheit eine Niederlage? Natürlich nicht. Die Rede – sie wurde wirklich für den Fall des Scheiterns von Apollo 11 geschrieben – wurde nie gehalten. Und doch gibt es diese Filmaufnahme.

Im vergangenen Jahr haben Künstler und Computerwissenschaftler den ehemaligen US-Präsidenten Richard Nixon digital zum Leben erweckt und ihn die Fernsehansprache doch noch halten lassen. Sein Aussehen, seine Stimme passen perfekt – für Laien ist das Video nicht als Fälschung zu erkennen.

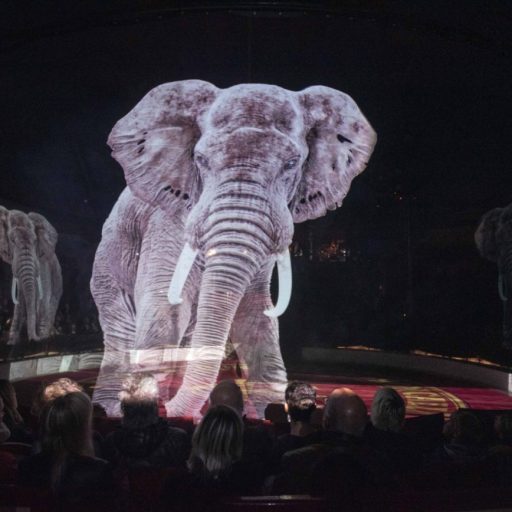

Noch nie war es so leicht, so täuschend echt Bewegtbilder zu manipulieren, weitgehend automatisch und mit recht geringem technischem Aufwand. Der Unterhaltungsindustrie bietet die Technik enorme kreative Möglichkeiten. Doch in Zeiten von Fake News birgt sie auch große Risiken für Politik und Gesellschaft.

Algorithmen lernen von selbst, Muster in Bildern zu erkennen

Möglich wird die Videomanipulation durch die rasante Entwicklung des Maschinellen Lernens, des Deep Learning: Ein Algorithmus lernt von selbst, Muster in Bildern zu erkennen. Ähnlich dem menschlichen Gehirn besteht er aus einem Netzwerk, das sich während des Lernprozesses anpasst. Je größer – oder tiefer – das Netzwerk ist, umso bessere Ergebnisse liefert es.

Daher hat sich für solche Videos das Kunstwort »Deepfake« etabliert, bestehend aus den englischen Wörtern für »tief« und »Fälschung«. Ein Künstliches Neuronales Netz lernt anhand von möglichst vielen Bildern einer Person, ihr Gesicht auf seine wesentlichen Merkmale zu reduzieren. Dabei extrahiert es unter anderem Informationen darüber, ob die Augen offen sind, die Mundwinkel nach oben gerichtet oder der Blick zur Seite gewandt. Was genau das Netz als »wesentlich« betrachtet, entscheidet es allerdings selbst, das Resultat ist für seine menschlichen Trainer oft gar nicht nachvollziehbar. Wichtig ist nur, dass es alle Aufnahmen eines Gesichts auf das gleiche Set von Merkmalen reduziert. Es kann dann zwischen der Mimik eines Gesichts und seinem Aussehen unterscheiden. Entsprechend kann es das Aussehen gegen das eines anderen Gesichts austauschen, während die Mimik gleich bleibt.

Einmal Daniel Craig Grimassen schneiden lassen? Per Deep Learning kein Problem. Die Mimik einer Person (links) wird auf ein Video des Schauspielers (rechts) so übertragen, das nun Craig die Mimik hat (unten).

Wie Deepfakes gemacht werden, wie sich auch Stimmen imitieren lassen, wie die neue Technologie die Filmindustrie revolutionieren werden, aber auch zu einer Gefahr für die Demokratie werden können, lesen Sie der neuen P.M., Ausgabe 09/2020.

Weitere Tipps zu drei faszinierenden Deepfake-Videos:

Perfekte Imitation: Eines der beeindruckendsten Deepfakes zeigt einen Imitator, der beim Rezitieren eines Gedichts in die Haut vieler berühmter Schauspieler schlüpft:

Vielsagendes Lächeln: Mittlerweile reicht eine einzelne Aufnahme einer Person aus, um aus ihr ein Fake zu erstellen. Oder ein Gemälde einer Person: In einem Video wurde das Gesicht der »Mona Lisa« zum Leben erweckt:

Gruseliges Lächeln: Autor Thomas Brandstetter war tief beeindruckt, als er in »Shining« plötzlich Jim Carrey statt Jack Nicholson wahnsinnig werden sah: