Mal erkennt sie Krebs früher als jeder Arzt, mal zögert sie im Straßenverkehr – mit fatalen Folgen. Künstliche Intelligenz trifft Entscheidungen, die unser Leben verändern. Doch verstehen wir wirklich, wie sie funktioniert?

Text: Florian Gahn

Eine Künstliche Intelligenz soll Krankheiten vorhersagen – besser als jeder Arzt.

Am Mount Sinai Hospital in New York arbeitet ein Forscherteam um Riccardo Miotto und Joel Dudley an einem System namens „Deep Patient“. Die Maschine hat sich durch 700.000 Patientenakten gefressen – voll mit Laborwerten, Diagnosen und Notizen – und gelernt, Muster zu erkennen, die menschlichen Ärzten verborgen bleiben.

Nun folgt der Härtetest: Mit neuen Daten soll die KI die Zukunft von Patienten voraussagen. Und sie liefert. Krebsarten erkennt „Deep Patient“ mit erstaunlicher Präzision – besser als etablierte Verfahren. Dann folgt die Königsdisziplin: Schizophrenie. Die KI identifiziert auffällig unauffällige Patienten – und liegt damit häufig richtig. Viele von ihnen entwickeln später tatsächlich psychotische Symptome.

Die Hoffnung ist groß: frühere Therapien, gerettete Leben. Doch die Euphorie kippt, als jemand die entscheidende Frage stellt: „Woran hat die Maschine das erkannt?“ Blutwerte? Medikamentenkombinationen? Niemand weiß es. Denn das System kann seine Entscheidung nicht erklären – es sagt nur: „Die Wahrscheinlichkeit ist hoch.“

Beunruhigendes Schweigen

Um zu verstehen, warum dieses Schweigen so beunruhigend ist, müssen wir einen Blick unter die Motorhaube werfen. In der „guten alten Zeit“ der Programmierung war Software wie ein preußischer Beamter: Sie folgte strikten Regeln. Ein Programmierer schrieb: „WENN der Blutdruck über 140 ist, DANN warne vor Hypertonie.“ Jede Entscheidung war transparent, jeder Fehler im Code nachvollziehbar.

Moderne KI, speziell das sogenannte „Deep Learning“, funktioniert anders. Sie ist kein Beamter, sie ist eher wie ein Kleinkind, das man in eine Bibliothek sperrt. Man füttert das System nicht mit starren Regeln, sondern mit Beispielen. Man zeigt ihm tausende Bilder von gesunden Lungen und tausende von kranken. Dann lässt man das neuronale Netz allein.

Im Inneren der Software beginnen nun Millionen künstlicher Neuronen zu feuern. Sie verknüpfen sich, gewichten Verbindungen neu, bilden Schichten über Schichten. Anfangs rät die Maschine wild. Doch jedes Mal, wenn sie falsch liegt, bekommt sie einen mathematischen Klaps (die Fehlerkorrektur oder „Backpropagation“).

Nach unzähligen Durchläufen hat das System eine „Intuition“ entwickelt. Es erkennt Muster, die für uns Menschen unsichtbar sind. Aber diese Muster sind nicht in klaren Regeln abgelegt, sondern als diffuses Rauschen in Millionen von Zahlenwerten (Parametern) verteilt. Fragen Sie das Netz, warum es auf diesem Röntgenbild ein Karzinom sieht, und es antwortet Ihnen mit einer Matrix aus Gleitkommazahlen.

Falscher Grund – richtiges Ergebnis

Das klingt nach Magie, birgt aber eine massive Gefahr: Die KI könnte aus den falschen Gründen das Richtige tun. Ein mittlerweile berüchtigtes Beispiel aus der Dermatologie zeigt das Problem. Eine KI sollte lernen, bösartige Muttermale von gutartigen zu unterscheiden. Im Labor war sie brillant. Besser als jeder Hautarzt. Doch als man ihr Bilder aus einer anderen Klinik zeigte, sank die Trefferquote massiv.

Des Rätsels Lösung: Auf vielen Trainingsbildern der bösartigen Tumore war ein Lineal zu sehen (weil Ärzte verdächtige Stellen oft vermessen). Die KI hatte nicht gelernt, Krebs zu erkennen. Sie hatte gelernt: „Wenn Lineal im Bild, dann Krebs.“ Sie war ein „Kluger Hans“ – benannt nach jenem Pferd im frühen 20. Jahrhundert, das angeblich rechnen konnte, in Wahrheit aber nur die feinen, unbewussten Körpersignale seines Besitzers las. Solche „Schmalspur-Experten“ sind gefährlich, wenn wir nicht wissen, worauf sie schauen.

Tödliche Black Box

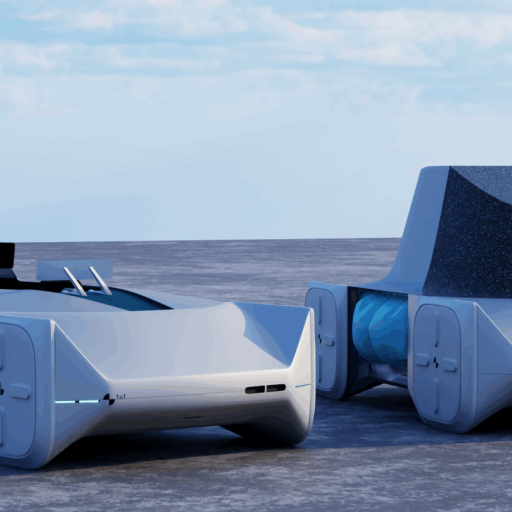

Das Unbehagen wächst, wenn es nicht mehr um Muttermale geht, sondern um Sekundenentscheidungen im Straßenverkehr. März 2018, Tempe, Arizona. Ein autonomer Testwagen von Uber erfasst eine Frau, die ihr Fahrrad über die dunkle Straße schiebt. Der Unfall endet tödlich. Die spätere Analyse der Log-Dateien zeigte das Drama im elektronischen Gehirn des Wagens. Die Lidar- und Radarsensoren hatten tatsächlich ein Hindernis registriert – die Rohdaten waren da. Doch die Software war verwirrt. Erst klassifizierte der Algorithmus den Schatten als „Auto“, dann als „Sonstiges“, dann als „Fahrrad“. Das System schwankte bei der Interpretation der Daten hin und her, unfähig, die Situation in eine bekannte Schublade zu stecken.

Da die Programmierer das System so justiert hatten, dass es nicht bei jedem unklaren Sensor-Rauschen eine Vollbremsung hinlegt, entschied die Black Box fatalerweise: Weiterfahren. Hier zeigt sich das Paradoxon: Wir bauen Systeme, die statistisch gesehen oft sicherer agieren als der unaufmerksame Mensch, aber wenn sie versagen, tun sie es auf eine so fremdartige Weise, dass es uns schaudern lässt.

Rätselhafte Intelligenz

Können wir der KI das Sprechen beibringen? Ein Forschungsfeld namens „Explainable AI“ (Erklärbare KI) versucht genau das. Forscher entwickeln Methoden, um die Black Box zu verhören. Eine Technik sind sogenannte „Heatmaps“. Wenn die KI sagt: „Das ist eine Katze“, legt man eine Farbschablone über das Bild, die anzeigt, welche Pixel für die Entscheidung wichtig waren. Leuchten die Ohren und Schnurrhaare rot? Gut. Leuchtet der grüne Rasen im Hintergrund rot? Schlecht – dann hat die KI nur gelernt, dass Katzen meistens draußen sitzen.

Doch es bleibt ein Dilemma. Je komplexer und leistungsfähiger eine KI ist, desto schwerer ist sie oft zu erklären. Ein einfaches Modell ist transparent, aber weniger präzise. Ein tiefes neuronales Netz ist oft genial, aber verschwiegen. Wir müssen uns wohl daran gewöhnen, mit einer Intelligenz zusammenzuleben, die wir nutzen, aber nie ganz durchschauen werden.

Wir stehen vor einer Wahl: Wollen wir den perfekten Diagnostiker, der uns heilt, aber nicht sagen kann warum? Oder den mittelmäßigen, der uns alles erklären kann, aber den Tumor übersieht?

Die Antwort darauf müssen wir geben, nicht die Maschine.

KI-Glossar: 3 Begriffe zum Mitreden

Neuronales Netz

Stellen Sie sich das Gehirn einer modernen KI wie ein riesiges Sandwich vor. Ganz oben kommen die Daten rein (z.B. Pixel eines Bildes), ganz unten kommt das Ergebnis raus („Katze“). Dazwischen liegen Dutzende Schichten aus künstlichen Neuronen – der „Belag“. Jedes Neuron ist mit vielen anderen verbunden. Die Magie passiert in den mittleren Schichten (Hidden Layers): Hier werden simple Linien zu Formen, Formen zu Augen und schließlich zu einem Gesicht zusammengesetzt. Es ist eine mathematische Knetmasse, die sich selbst formt.

Backpropagation

Wie lernt dieses Sandwich? Durch Bestrafung. Das ist „Backpropagation“ (Fehlerrückführung).

Stellen Sie sich vor, die KI soll einen Hund erkennen, sagt aber „Toaster“. Jetzt kommt der Lehrer (der Algorithmus) und ruft: „Falsch!“. Er läuft vom Ergebnis rückwärts durch das ganze Netz zurück. Jedem Neuron, das zur falschen Entscheidung „Toaster“ beigetragen hat, dreht er den Saft ab (verringert das Gewicht). Den Neuronen, die fast „Hund“ gesagt hätten, dreht er den Saft auf.

Diesen Vorgang wiederholt das System millionenfach.

Bias

Eine KI ist nicht objektiv. Sie ist so voreingenommen wie die Daten, mit denen sie gefüttert wurde. Das nennt man Bias (Verzerrung). Ein berühmtes Beispiel lieferte Amazon: Der Konzern entwickelte eine KI, die Bewerbungen automatisch sortieren sollte. Nach einiger Zeit fiel auf, dass das System Frauen systematisch benachteiligte. Der Grund? Die KI wurde mit den Lebensläufen der letzten 10 Jahre trainiert – und die kamen in der Tech-Branche überwiegend von Männern. Die KI schlussfolgerte daraus fälschlicherweise: „Männer sind bessere Kandidaten“ und strafte Bewerbungen ab, die das Wort „Frauen“ (z.B. „Frauen-Schachclub“) enthielten. Deshalb gilt: Garbage In, Garbage Out. (Müll rein, Müll raus).